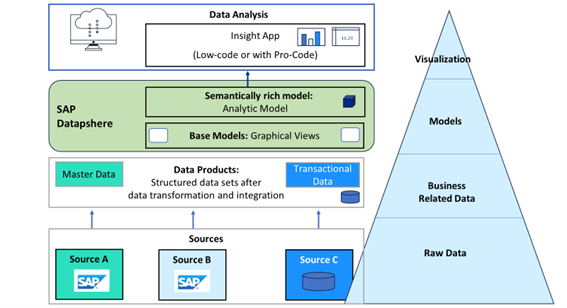

Datasphere es la nueva herramienta de SAP para gestionar los datos de nuestra empresa. Permite centralizar todos los datos en un único punto, sin importar si se trata de un origen SAP o no SAP, tanto local como en la nube estén o no estructurados.

Fuente: SAP

Vamos a detallar las herramientas que tiene Datasphere para obtener y tratar los datos.

Modelización entre el usuario técnico y el usuario de negocio

Datasphere cambia el paradigma de modelización de los datos que vamos a utilizar para reporting. En esta ocasión SAP ha divido el trabajo en dos partes:

- Generador empresarial (Business Builder): como su propio nombre indica, genera todo lo relativo al negocio. Enfocado a usuarios no técnicos, la idea es exprimir el concepto de low code/no code, por lo que de forma gráfica permite crear o terminar la preparación de los datos para SAP Analytics Cloud u otras herramientas de reporting.

- Generador de datos (Data Builder): enfocado a un perfil más técnico, se utiliza para preparar los datos de modo que se pueden terminar de refinar en el generador empresarial o directamente se pueden paras a reporting.

Los datos obtenidos y tratados desde estos dos apartados de Datasphere se pueden utilizar desde SAP Analytics Cloud, por lo que, en función de los perfiles de usuarios presentes en la empresa, se puede adaptar el flujo de modelización de Datasphere a nuestro negocio.

Generador empresarial, usuario de negocio

En el generador empresarial nos encontramos los siguientes elementos:

Las dimensiones (Dimensions) y los hechos (Facts) son lo que SAP agrupa en entidades empresariales (Business Entities). Las dimensiones se utilizan generalmente para datos maestros, y al crearlas deben tener obligatoriamente una clave definida. En el caso de los hechos, su uso está enfocado a los datos transaccionales, para lo cual es necesario definir por lo menos un indicador.

Tras crear las dimensiones y los hechos, se puede definir un modelo de hechos (Fact Model), que son modelos reutilizables que agilizan la creación de otros modelos que compartan el mismo contexto empresarial. De este modo, si tenemos por ejemplo un cálculo que se va a repetir, podemos gestionarlo desde un único punto. Para crearlo, podemos utilizar como origen las dimensiones y los hechos que tengamos en el sistema, así como otros modelos de hechos previamente definidos.

Todos estos elementos convergen en el modelo de consumo (Consumption Model), la base para consumir los datos que hemos ido obteniendo y definiendo previamente. Al definir un modelo de consumo vamos a construir una o más perspectivas, las cuales explotaremos desde una herramienta de visualización, como puede ser SAP Analytics Cloud.

¿Y qué hay de los permisos para visualizar los datos? Fácil, para ello contamos con el escenario de autorización (Authorization Scenario), que es donde podemos definir qué datos van a ser relevantes en función del contexto de cada usuario. Para ello es necesario definir un control de acceso a datos en el generador de datos que veremos a continuación, de modo que se restrinja el acceso a la información según sea necesario. Los escenarios de autorización van a ser opcionales únicamente si el modelo es público, en caso contrario vamos a tener que definirlo.

Generador de datos, usuario técnico

Por la parte del generador de datos, nos encontramos con los siguientes elementos:

Dividiendo estas herramientas en base a su función tenemos:

Adquiriendo el dato:

Para realizar la adquisición de datos tenemos varios elementos. Comenzando por las tablas (Tables), que nos permiten cargar datos desde diferentes orígenes, como puede ser un fichero CSV, CSN (Core Data Schema Notation) o incluso importar una tabla desde una conexión con un sistema externo. Después podemos hacer uso del flujo de datos (Data Flow) para mover y transformar los datos de manera gráfica, con el simple gesto de arrastrar y soltar los orígenes de datos necesarios. También nos permite realizar uniones, añadir otros operadores para crear o eliminar columnas, agregar datos, etc. Si queremos hacer cambios mediante código, tenemos habilitado un espacio en el que podemos hacer scripting utilizando Python como lenguaje de programación, antes de escribir en la tabla de destino.

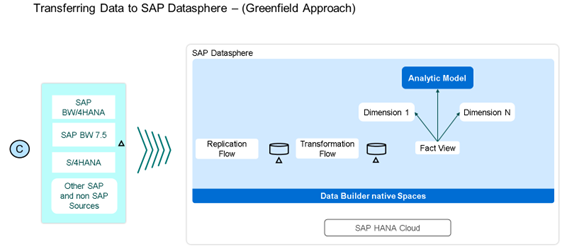

También tenemos el flujo de replicación (Replication Flow) que nos sirve para copiar múltiples objetos de datos de un origen a un destino. Este origen puede ser un CDS View, objetos de proveedores ODP o tablas que tengan una clave primaria.

¿Y cómo cargamos la información nueva? Mediante una cadena de tareas (Task Chain), la cual nos permite agrupar múltiples tareas para lanzarlas una única vez o periódicamente, programando cuándo queremos que se ejecute y obteniendo así todos los cambios realizados sobre los datos.

Preparando el dato:

Todo esto está muy bien, pero, ¿cómo puedo enfocar los datos a lo que necesito?

Para ello tenemos la vista gráfica (Graphical View) que es una herramienta no code la cual nos permite consultar los datos de origen en una interfaz gráfica e intuitiva, para generar consultas arrastrando y soltando los elementos disponibles, pudiendo realizar uniones, agregaciones y filtrado de datos, etc. Y si la vista gráfica se nos queda corta, tenemos la vista SQL (SQL View) que nos permite utilizar toda la potencia que nos brinda tanto SQL estándar como SQL Script para escribir las sentencias necesarias en un práctico editor. También nos permite aprovechar la funcionalidad de los table function, consultando directamente a los datos de origen.

Si lo que queremos es cargar datos de uno o más orígenes aplicando transformaciones, y sacar el resultado en una tabla de destino, tenemos el flujo de transformación (Transformation Flow), que nos permite ejecutar estas acciones sobre tablas locales y remotas, vistas, etc., permitiendo una carga tanto delta como completa.

Fuente: SAP

También hay ocasiones en las que queremos fusionar dos conjuntos de datos cuya unión no es posible porque el campo de unión no es idéntico, por ejemplo, cuando queremos unir datos de un origen SAP con otro origen no SAP. Aquí es donde entra en juego la búsqueda inteligente (Intelligent Lookup), ya que nos permite fusionar datos de dos entidades aunque su unión pueda presentar problemas, ya que es una herramienta que provee de una armonización de datos interactiva y centrada en el negocio que facilita completar los datos entre dos fuentes diferentes.

Finalmente, para la parte de la preparación del dato tenemos la funcionalidad de “entidad – modelo de relación” (Entity-Relationship Model). Desde aquí podemos importar, visualizar, editar y desplegar múltiples tablas y vistas juntas. A modo de ejemplo se puede utilizar para entender mejor un subconjunto de entidades para poder comunicar esta información a las personas interesadas de nuestra organización.

Modelando el dato:

Para modelar el dato en el generador de datos, SAP Datasphere nos lo pone fácil, centralizando todo en la creación del modelo analítico (Analytic Model), lo cual es perfecto para dejar el dato preparado para su consumo en SAP Analytics Cloud u otras herramientas de reporting. Permite a los usuarios crear y definir los datos necesarios para resolver los objetivos analíticos que necesitemos, respondiendo a diferentes preguntas de negocio. Tiene múltiples beneficios, como puede ser el facilitar la creación de modelos a un usuario más orientado a negocio, maximizar la reutilización de objetos, un mejor control de los datos de salida, etc.

¿Y los permisos?:

Finalmente tenemos el control de acceso a datos (Data Access Control). Como su propio nombre indica, nos permite controlar en todo momento qué datos puede visualizar cada usuario, permitiendo aplicar seguridad a nivel de fila.

Como hemos podido ver, SAP Datasphere permite un control total del dato y también permite modelar y llegar a generar informes finales tanto por usuarios técnicos como por usuarios de negocio. Su integración con SAP Analytics Cloud facilita mucho la generación de cuadros de mando con esta herramienta, aunque también es posible utilizar otras herramientas de reporting.

Déjanos tus preguntas en los comentarios o contacta con nosotros para resolver cualquier duda que tengas.

Más información:

Quizas te pueda interesar

¿Qué es Databricks

y por qué está transformando la gestión del dato?

En los últimos años, las empresas se han enfrentado a un crecimiento exponencial del volumen de datos, tanto en cantidad como en variedad. Sistemas transaccionales, aplicaciones en la nube, sensores, plataformas digitales y herramientas de terceros generan información...

Analítica embebida y SAP Analytics Cloud

como vía de análisis de presupuesto.

La funcionalidad de SAP Analytics Cloud es de largo conocida, así como su potencial para el reporte de información y su posterior análisis. En un entorno donde la agilidad y la transparencia financiera son esenciales, explotar de forma eficaz la información analítica...

Seguridad a nivel de fila (RLS) en Power BI

En la actualidad, una de las necesidades fundamentales en la gestión de datos es la capacidad de filtrar y restringir el acceso a la información de manera eficiente y segura. La seguridad de los datos es esencial para garantizar la privacidad y el cumplimiento...